SЕО умер, да здравствует AEO и GEO? Спойлер: нет

Что сделать, чтобы попасть в рекомендации нейросетей в Поиске, рассказывает руководитель отдела SEO digital-агентства «Четвертый Рим» Александр Никитин.

Что такое AEO (Answer Engine Optimization). Это современный подход к оптимизации контента, цель которого — сделать сайт источником прямых и кратких ответов для поисковых систем, голосовых помощников и нейросетевых сервисов.

SEO = позиции в выдаче. AEO = видимость и цитирование в ИИ-ответах.

То есть AEO — это новое SEO для эпохи ИИ:

SEO фокусируется на том, чтобы ваш сайт занимал высокие позиции в традиционной поисковой выдаче Google или Яндекса.

Основная цель SEO — получить клики и трафик, используя ключевые слова, обратные ссылки и техническую оптимизацию.

AEO ориентируется на искусственный интеллект и генеративные системы — Google AI Overviews, Яндекс Поиск с Алисой и т. д.

Основная цель AEO — повысить узнаваемость и доверие к сайту, используя попадание в ответы ИИ. Не так важно, кликнет ли после пользователь на ссылку.

Как нейросети меняют ландшафт SEO и подходы к ранжированию

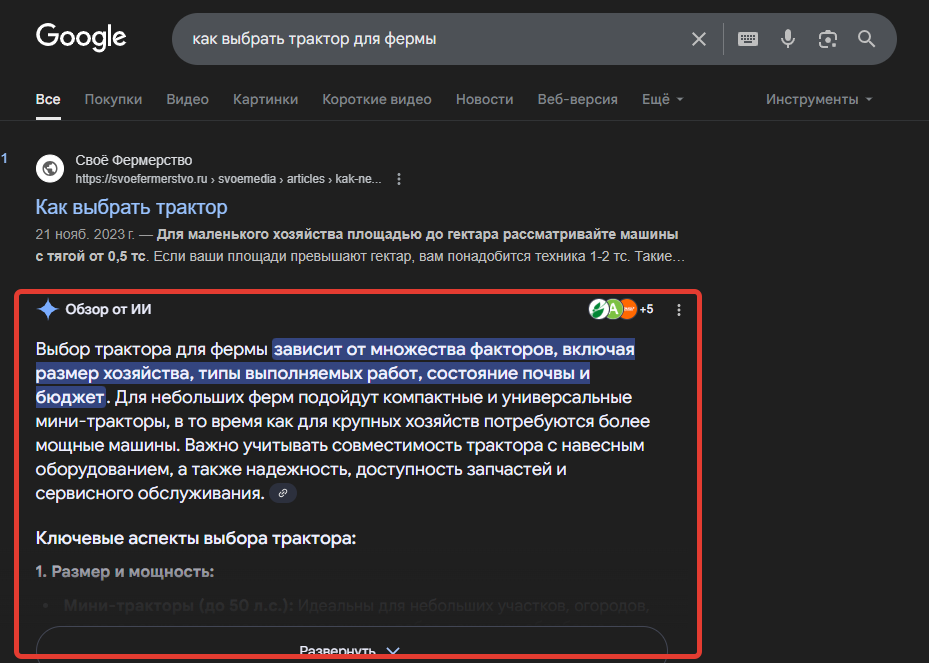

Если раньше сайты боролись за попадание в топ-10 выдачи Поиска Google и Яндекса, то теперь бороться нужно за место в ИИ-ответах. Особенно остро встал вопрос в 2025 году — после внедрения блоков нейроответов в выдачу поисковых систем.

Доля поисковых запросов, для которых генерируются ИИ-ответы, значительно выросла к середине 2025 года:

-

В Google показатель превысил 50%. Это означает, что более половины всех поисковых сессий в Google начинаются не с традиционного списка ссылок, а со сгенерированного нейросетью резюме.

Причем еще в начале 2025 года доля ИИ-ответов в Google составляла около 13–15% — то есть в течение нескольких месяцев она увеличилась кратно.

-

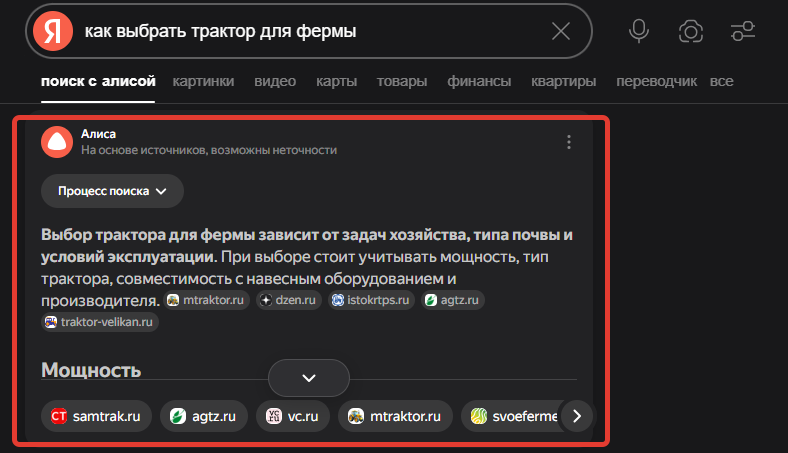

В Яндексе к середине 2025 года на 25% всех запросов в Поиске отвечает Алиса — и это с учетом того, что Поиск с Алисой запустили только в мае.

Пока всё это касается по большей части выдачи по информационным запросам. Для коммерческих и навигационных запросов нейроответы пока встречаются реже, но и там их доля увеличивается.

То есть ИИ сегодня играет ключевую роль в алгоритмах поисковых систем.

Как работают алгоритмы поисковых систем на основе ИИ

Алгоритмы Google и Яндекса уже давно работают на основе ИИ. Искусственный интеллект помогает поисковым системам понимать смысл запроса и контента, а не только набор слов.

Ключевые алгоритмы Google:

RankBrain (2015) — первое ML-решение в Google, которое понимает редкие/новые запросы, сопоставляет с похожими;

BERT (2019) — нейросеть, понимающая контекст (например, в запросе «Купить билет из Москвы в Париж» понимает, что направление важно);

MUM (2021) — мультимодальная модель, которая может переводить знания между языками (например, для подготовки ответа на запрос «Как подготовиться к походу в Фудзи» учитывает статьи на других языках, фото и видео).

Ключевые алгоритмы Яндекса:

Палех (2016) — первая нейросеть, которая начала понимать длинные запросы и сопоставлять их с заголовками документов;

Королёв (2017) — расширенная модель: учитывает весь текст документа, а не только заголовки;

Катран — оптимизация Поиска по миллиардам векторных представлений (ускоряет «смысловой поиск»);

YATI (2020) — модель на уровне BERT (помогает понимать контекст и семантику текста).

Теперь разберем наглядно, в чем поисковики используют ИИ.

|

Функция |

Процесс работы |

|

Обработка запроса |

Если раньше Поиск просто сопоставлял ключевые слова, то теперь нейросети анализируют контекст, намерение, синонимы, форму слова. Поисковик пытается понять, что хочет пользователь: купить, узнать, сравнить, решить проблему и пр. |

|

Анализ контента |

Алгоритмы NLP (Natural Language Processing) оценивают, о чем страница: определяют тему, извлекают факты, выявляют структуру (заголовки, списки, таблицы). Алгоритмы сравнивают смысл страницы с намерением пользователя |

|

Ранжирование по смыслу |

ИИ вычисляет не только количество совпадений с запросом, но и насколько страница отвечает на вопрос |

Для бизнеса это значит, что контент должен быть не только SEO-оптимизирован по структуре и ключевым словам, но и должен отвечать на реальные вопросы и задачи аудитории. Нужно:

-

готовить контент, ориентированный на вопросы и задачи клиентов (вопросы/ответы, гайды, инструкции, чек-листы);

-

работать с брендом и экспертностью — чтобы ИИ выбирал именно вас в качестве источника.

Как попасть в нейроответы и выдачу нейросетей — стратегия по продвижению

Тут нужно понимать, что AEO не заменяет SEO, а дополняет его. Поэтому многие принципы продвижения вам уже знакомы.

К тому же находиться в топ-10 результатов выдачи по-прежнему важно: большинство информации для ИИ-ответов берется с сайтов, которые находятся на первой странице.

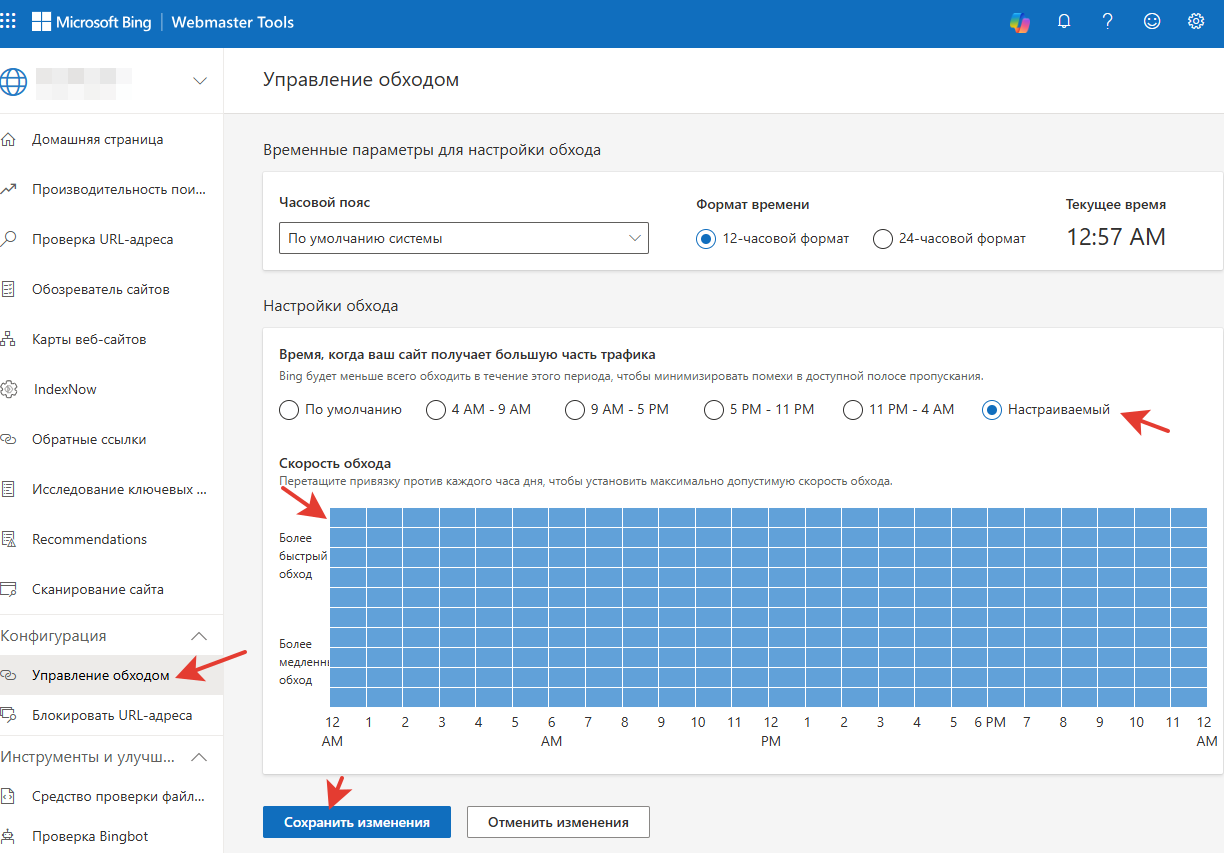

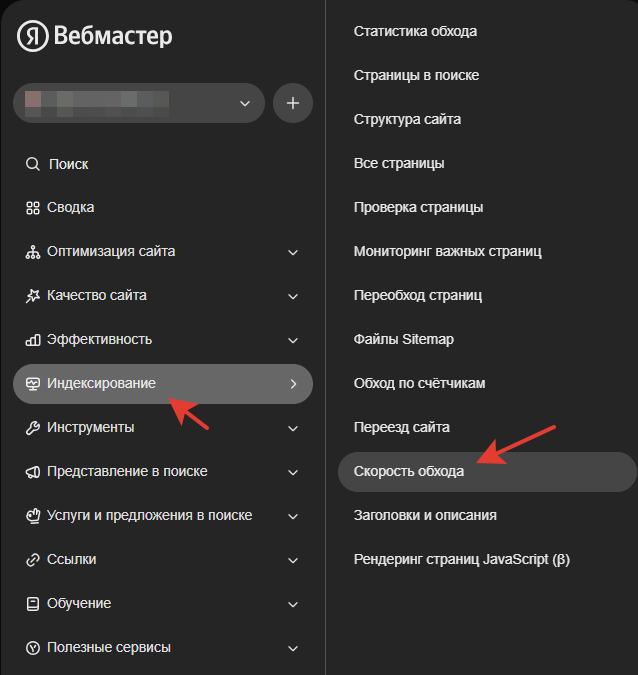

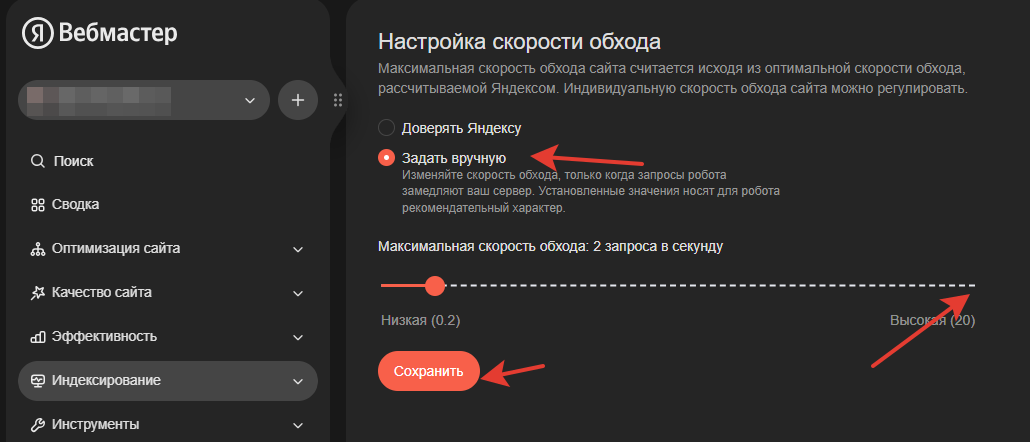

Настройте скорость индексации

Быстрая индексация позволяет контенту оперативно обновляться в базе данных поисковых систем, это повышает вероятность его цитирования в ответах Алисы. Всё настраивается в Яндекс Вебмастере.

Используйте подходящую разметку

Это помогает нейросетям понимать структуру контента на странице и цитировать его в ответах. У правильно размеченной страницы больше шансов быть выбранной в качестве источника для ответа. Выбирайте разметку, исходя из типа контента:

-

блоги, статьи и новости — Article;

-

вопросы и ответы — FAQPage;

-

инструкции — HowTo;

-

товары — Product;

-

отзывы — Review.

Проверить, присутствуют на странице структурированные данные или нет, а также выявить ошибки, можно с помощью инструментов:

Проверяйте скорость загрузки сайта

У ИИ-систем жесткие ограничения по времени обработки. Поэтому важно обеспечить быстрое время отклика сервера и загрузки контента, минимизировать использование JS-скриптов. Также это важно для голосового поиска — например, Алиса ждет мгновенный ответ, а если сайт тормозит, она выберет другой источник.

Проверить скорость загрузки можно с помощью инструмента PageSpeed Insights.

Работайте с E-E-A-T факторами

E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) — принцип, который использует Google для оценки качества контента. Переводится как «опыт, экспертность, авторитетность и надежность». Всегда нужно:

-

указывать авторов;

-

создавать страницы авторов;

-

добавлять ссылки на авторитетные источники;

-

добавлять комментарии экспертов;

-

регулярно обновлять (актуализировать) контент.

Это повышает доверие ИИ к контенту на сайте.

Проверяйте базовую техническую оптимизацию

Тут всё ясно: проверяйте robots.txt, ошибки 404, атрибут rel=canonical, сертификат https и т. д.

Тестируйте новые форматы контента

ИИ часто берет в цитирование форматы:

-

Q&A (вопрос—ответ);

-

инструкции;

-

сравнения;

-

чек-листы.

Структурируйте текст

Чем проще и структурированнее подана информация, тем выше шанс, что ее возьмет ИИ. Важны:

-

четкая иерархия заголовков (H1—H6);

-

разбивка на абзацы;

-

добавление списков, таблиц, изображений, инфографики, видео и т. д.

-

корректно заполненные метатеги;

-

перелинковка между страницами.

Бонус не по AEO, а по GEO: продвижение в ChatGPT

Коротко проговорим, что делать дополнительно, чтобы попасть также в выдачу генеративных ИИ вроде ChatGPT.

Настройте скорость индексации

Нужно добавить сайт в Bing Webmaster и настроить скорость индексации здесь. ChatGPT получает информацию в том числе через Bing Search Index — то есть чем быстрее и лучше сайт индексируется в Bing, тем выше шанс, что его страницы будут использоваться ChatGPT.

Проверяйте наличие и корректность файла sitemap.xml

Сами нейросети не ходят по таким файлам, но они используют данные поисковых индексов или специализированные API. Файл sitemap.xml ускоряет попадание страниц в индекс поисковых систем, следовательно, контент становится доступен для генеративных моделей. Особенно это важно для крупных многостраничных сайтов.

Подробнее про файл sitemap.xml, ограничения и требования, можно прочитать в справках Google и Яндекса. Мы лишь подсветим, что наиболее важным является элемент <lastmod> — в нем должны быть приведены дата и время последнего изменения страницы. Это помогает определить актуальность контента и необходимость его перехода.

Проверить корректность файла sitemap.xml можно с помощью Вебмастера.

Создайте файл llms.txt

llms.txt — это новый стандарт, созданный специально для помощи большим языковым моделям вроде ChatGPT, Gemini, Claude и пр. Он помогает им эффективнее сканировать и понимать контент веб-сайтов — быстрее находить и извлекать нужную информацию.

llms.txt не заменяет robots.txt или sitemap.xml, но является дополнением к ним. Главная цель llms.txt — помочь владельцам сайтов контролировать, какой контент будет использоваться для генерации ИИ-ответов.

Чтобы создать файл llms.txt:

-

откройте любой текстовый редактор и создайте новый документ;

-

назовите файл строго llms.txt (латиницей, без дополнительных расширений);

-

заполните файл ссылками на важные страницы, базовый шаблон:

[О компании] https://vas-site.ru/markdown/about.md

[Продукты] https://vas-site.ru/markdown/products.md

[Контакты] https://vas-site.ru/markdown/contacts.md

-

сохраните файл и разместите в корневой папке сайта (проверить доступ можно по адресу https://ваш-сайт.ru/llms.txt);

-

регулярно обновляйте содержимое, чтобы отражать актуальную информацию.

Для некоторых CMS есть готовые модули или плагины для создания файла llms.txt. Например, для WordPress.

Вывод

Как видите, SЕО жив и будет жив: все принципы остались прежними. AEO и GEO лишь дополняют его.

Ваша реклама на ppc.world

от 10 000 ₽ в неделю

Читайте также

SEO-продвижение в Яндексе и Google 2025 — интервью с Дмитрием Шаховым

SEO, AEO и GEO: что это вообще такое и зачем вам об этом знать? Чек-лист из 27 важных факторов для ранжирования

Последние комментарии